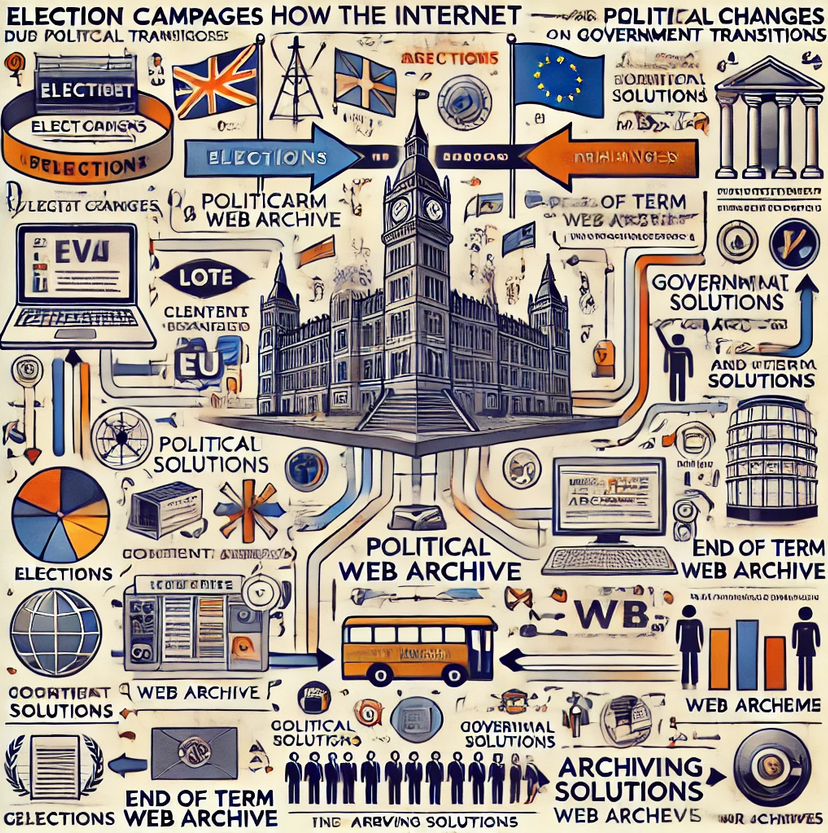

Veränderungen auf Regierungswebsites nach Wahlen oder durch einen Regierungswechsel Aktualisiert am 7. Februar 2025 Ein Regierungswechsel, insbesondere durch Wahlen, führt häufig zu Veränderungen auf offiziellen Internetseiten, insbesondere solchen von Ministerien, Behörden und Regierungsorganisationen. Diese Veränderungen lassen sich in verschiedene Kategorien einteilen: Welche Erkenntnisse gibt es oder welche Aspekte sind Gegenstand von Studien oder Untersuchungen? Bei […]